医学影像智能与机器人研究中心在医学影像分析算法公平性方面

取得重要进展

近年来,深度学习在各种医学影像分析应用中展现出了显著的性能。然而,研究指出,这些算法应用于特定人群时会存在一定的性能差异。例如,模型相较于青年、男性群体,在老年、女性群体中的预测表现较差。该问题被研究人员定义为“算法公平性(algorithm fairness)”。解决这一公平性问题已成为人工智能研究人员和临床医生共同的努力方向,中国科大苏州高等研究院医学影像智能与机器人研究中心(MIRACLE)针对这一问题展开了系统性研究,近期在该方向上取得了两项重要进展。

进展一:医学影像分析算法公平性综述被npj Digital Medicine接收

由于医学影像分析算法公平性的研究仍处于初步阶段,领域内缺乏对该问题的深入了解和分析。医学影像智能与机器人研究中心与中国科学院计算技术研究所研究团队合作发表综述论文“Addressing Fairness Issues in Deep Learning-Based Medical Image Analysis: A Systematic Review”,详细总结了医学影像分析算法中公平性有关研究现状。

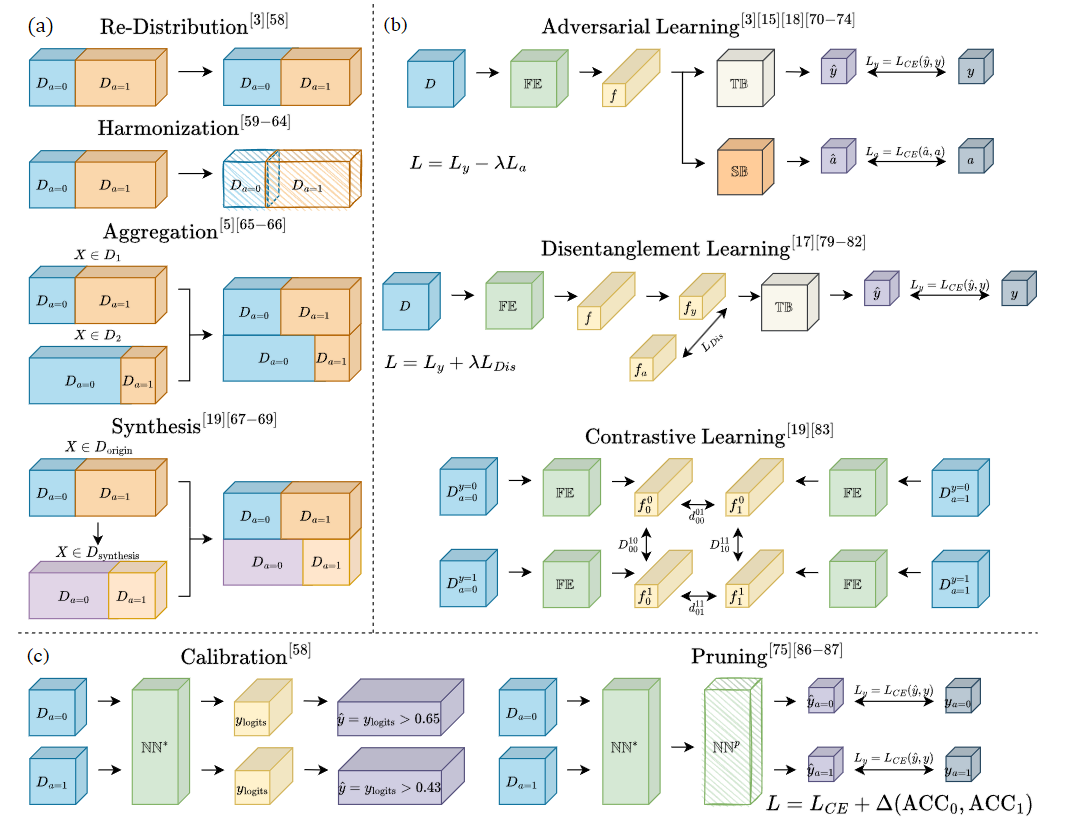

图一:现有不公平性弥补算法示意图

该综述深入探讨了在医学影像分析中解决公平性问题的当前进展,介绍了群体公平性(Group Fairness)的基础知识,归纳了现有医学影像分析算法公平性研究进展,按照公平性评估和不公平性弥补两大类对已有研究进行了深入分析。综述最后讨论了在建立公平的医学影像分析和医疗应用过程中现存的挑战和机遇。通过本篇综述,我们旨在促进人工智能研究人员和临床医生对公平性的一致性理解,推动不公平性弥补算法的发展,并为创建一个公平的医学影像分析系统做出贡献。

文章目前已被Nature出版社旗下npj Digital Medicine期刊接收。周少华教授为该文章通讯作者,第一作者为中国科大博士生徐梓康。

文章链接:

https://www.nature.com/articles/s41746-024-01276-5

进展二:医学影像分析大模型公平性基准被NeurIPS2024接收

基础模型(Foundation Models,FMs)的出现为医疗诊断中的自动分类和分割任务提供了前所未有的机会。然而,这些模型在应用于多样化且代表性不足的医疗群体时也引发了重大公平性问题。目前,缺乏全面的基准、标准化的流程以及易于适配的库来评估和理解基础模型在医学影像中的公平性表现,这导致在制定和实施确保各类患者群体公平结果的解决方案时面临重大挑战。

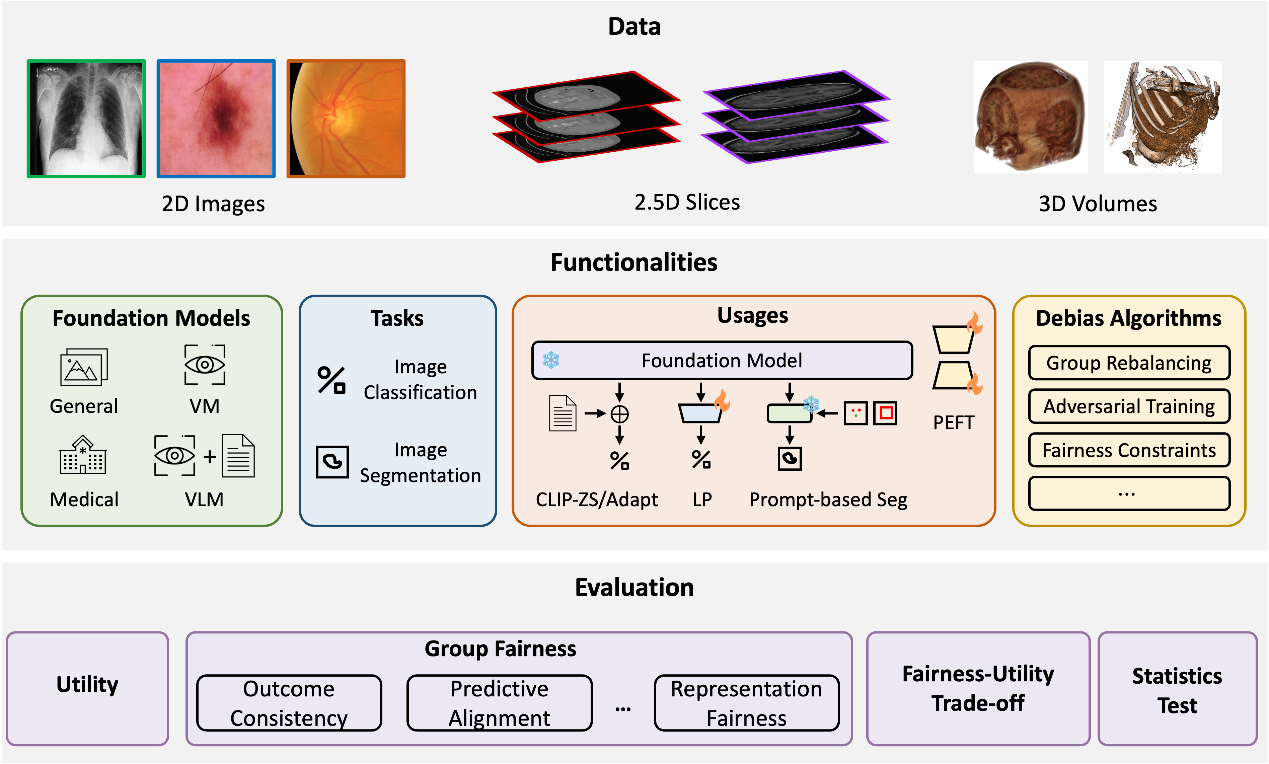

图二:FairMedFM基准总览图

医学影像智能与机器人研究中心(MIRACLE)与中国科学院计算技术研究所、香港中文大学(CUHK)、英属哥伦比亚大学(UBC)合作发表文章“FairMedFM: Fairness Benchmarking for Medical Imaging Foundation Models”,提出了FairMedFM,一个用于基础模型医学影像分析的公平性基准,对医学影像分析大模型中的算法公平性问题进行了详细的评测。

FairMedFM集成了17个常用的医学影像数据集,涵盖了不同的任务类型、成像模态、数据维度和敏感属性。它探索了20个广泛使用的基础模型,在不同使用方式下模型的公平性表现,揭示了不公平性的广泛存在、在不同模型上的性能与公平性的权衡、在相同数据集上存在一致性差异,现有的消除不公平方法效果有限等现象,为医学影像分析中的公平性评估奠定了基础。

相关文章被Neural Information Processing Systems (NeurIPS)2024 Dataset & Benchmark Track接收(接收率25.3%)。英属哥伦比亚大学李霄霄教授、中国科大周少华教授、香港中文大学窦琪教授为该文章共同通讯作者,英属哥伦比亚大学博士生金瑞楠、中国科大博士生徐梓康、香港中文大学博士生钟源为该文章共同第一作者。

文章链接:

https://arxiv.org/pdf/2407.00983

项目链接:

https://github.com/FairMedFM/FairMedFM